拒绝隐私焦虑,Win11 部署Cherry Studio过程记录

一、Cherry Studio 是什么?

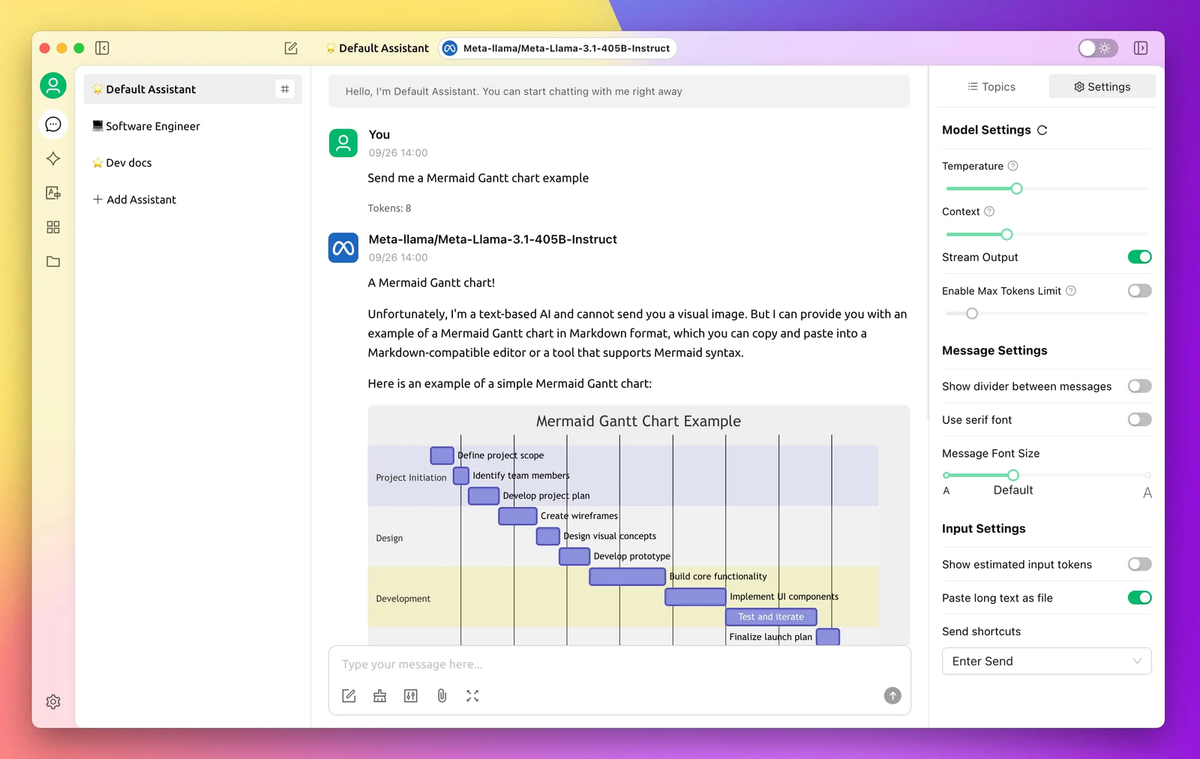

Cherry Studio 是一款功能强大的跨平台桌面客户端,旨在为用户提供灵活、高效的大型语言模型(LLM)交互体验。它支持多种主流云端模型(如 OpenAI、Gemini、Anthropic)以及本地模型(通过 Ollama 等运行),并内置 300 多个预配置 AI 助手,用户还可自定义专属助手以满足个性化需求。Cherry Studio 不仅支持多模型同时对话,还能处理多种文件格式(包括文本、图片、PDF 和 Office 文件),适用于文档分析、知识管理等场景。通过集成本地化选项,它为注重数据隐私的用户提供了理想解决方案。无论是开发者、研究者还是专业用户,Cherry Studio 都能以其友好的界面和强大的功能,助力提升生产力与创造力。

同类应用对比

Cherry Studio 是一款跨平台工具,专注多模型交互与本地支持,适合个人生产力提升;Dify 是开源 AI 开发平台,强调工作流与应用构建,面向企业和开发者;Ollama 提供简单本地 LLM 运行,注重隐私与易用性,适合研究者。

| 维度 | Cherry Studio | Dify | Ollama |

|---|---|---|---|

| 目标用户 | 个人、专业用户、开发者 | 开发者、企业 | 个人、开发者 |

| 核心功能 | 多模型交互、本地化支持 | 应用开发、RAG、工作流 | 本地 LLM 运行 |

| 模型支持 | 云端 + 本地(如 Ollama) | 数百种模型(云 + 本地) | 本地模型 |

| 易用性 | 中等(偏专业用户) | 高(可视化界面) | 高(简单命令行) |

| 开源性 | 部分开源(依赖 Ollama 等) | 完全开源 | 完全开源 |

| 隐私性 | 高(支持本地运行) | 中(需配置本地部署) | 高(完全本地) |

| 应用场景 | 通用(知识库、对话等) | 通用 AI 开发 | 本地模型测试与使用 |

| 扩展性 | 中等(依赖集成工具) | 高(丰富工具和 API) | 中等(需外部 UI 增强) |

- Cherry Studio:适合需要跨模型对比、灵活交互和本地化支持的个人或小型团队,强生产力和多功能性。

- Dify:适合开发者或企业快速构建复杂 AI 应用,尤其是需要工作流管理和知识库功能的场景。

- Ollama:适合对隐私敏感、希望在本地运行 LLM 的用户或研究者,简单高效但功能较单一。

相信很多人在年后这段时间已经在自己的电脑上安装了Ollama并且部署了DeepSeek模型,因为受限于个人电脑的性能,安装Ollama这种方式搭建知识库带来的体验并不好,使用门槛较高,我目前已经在自己的NAS上使用docker部署了Dify,怎么说呢,隐私性是得到了很好的提升,但是内网穿透网络下的使用体验也并没有那么理想,这种情况下可能Cherry Studio也许是最佳的选择。

二、软件的安装

Cherry Studio的安装过程非常简单,基本上可以说是傻瓜式安装,由于Cherry Studio是调用LLM的API来实现对本地知识库的创建和检索,如果你的本地已经部署了Ollama或者LM Studio,可以方便的调用本地模型,他同时提供了对大模型API的支持,如果你不介意,可以使用各类平台提供的API,可以大大降低了个人知识库部署的门槛。

2.1 软件安装包的获取

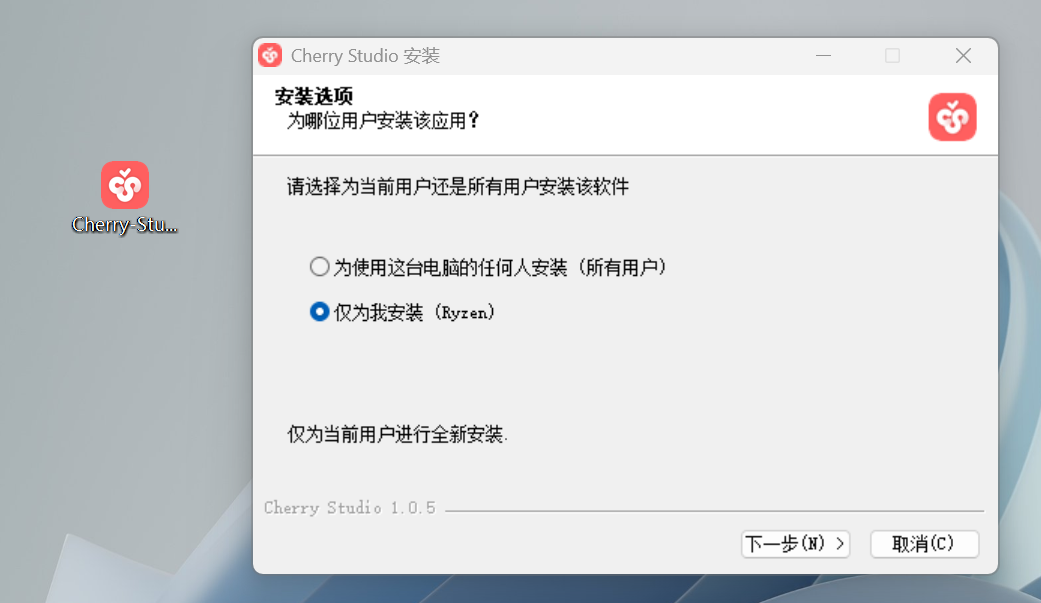

Cherry Studio目前支持在Windows 、Linux、Mac OS X下安装,最新的版本为v1.0.5,有条件的话,尽可能从官方源下载软件包,Cherry Studio 的本地安装包可以在以下地址获取(点进去,是夸克网盘的分享链接,88vip领取的会员终于派上了用场):

2.2 安装过程

双击下载好的Cherry Studio 安装包,按需选择用户、设置好安装目录,点击下一步即可。(注意安装时要以管理员身份运行)

安装完成后打开软件,显示如下界面:

此时,软件还没有办法调用大语言模型,需要我们获取模型的API后进行配置使用。

三、 配置模型

Cherry studio 支持包括本地在内的数十种平台的API,接下来以配置Deepseek的模型和通义千问模型服务为例,展示基本的模型配置过程:

3.1 推理模型deepseek的配置

第一步:获取deepseek api key:

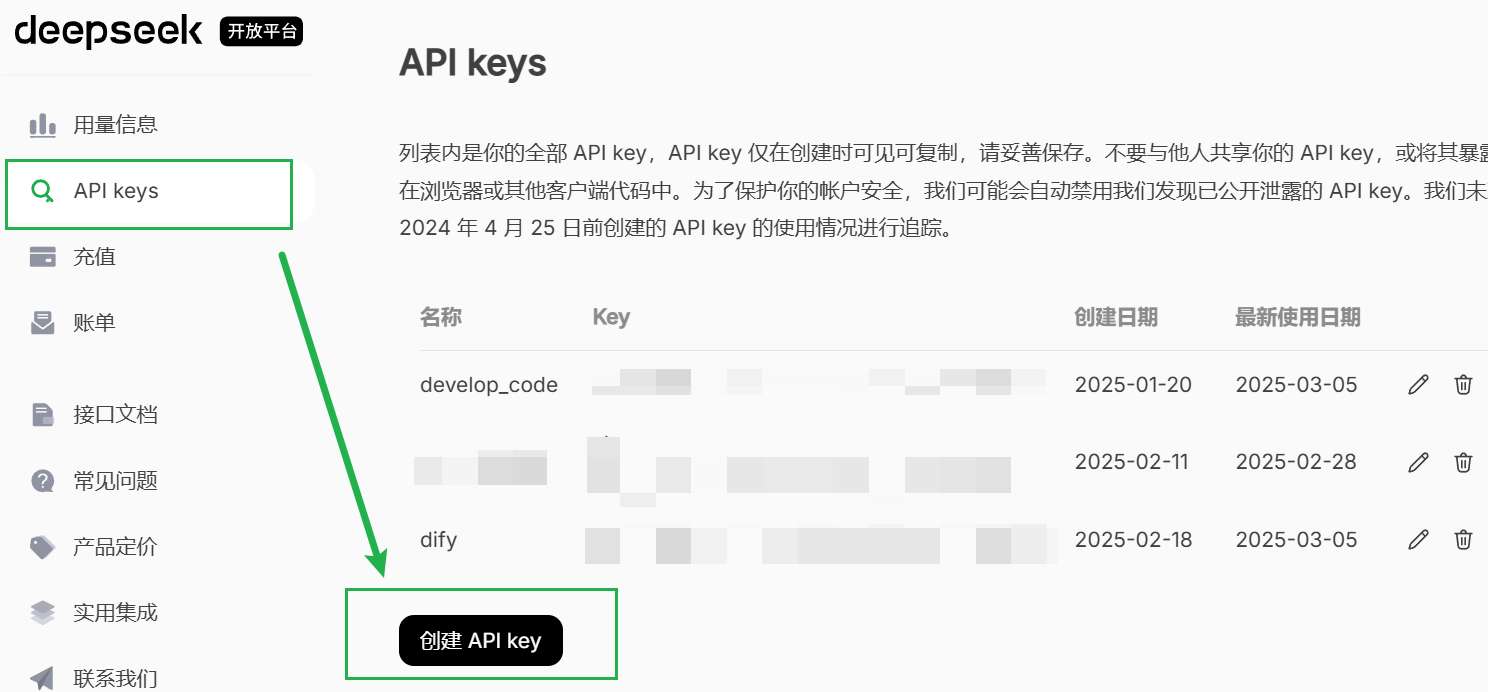

点击https://platform.deepseek.com/sign_in注册账户,领取赠送额度后点击左侧的API keys:

点击创建 API key 按钮,输入名称后即可创建一个key,记得复制保存!!

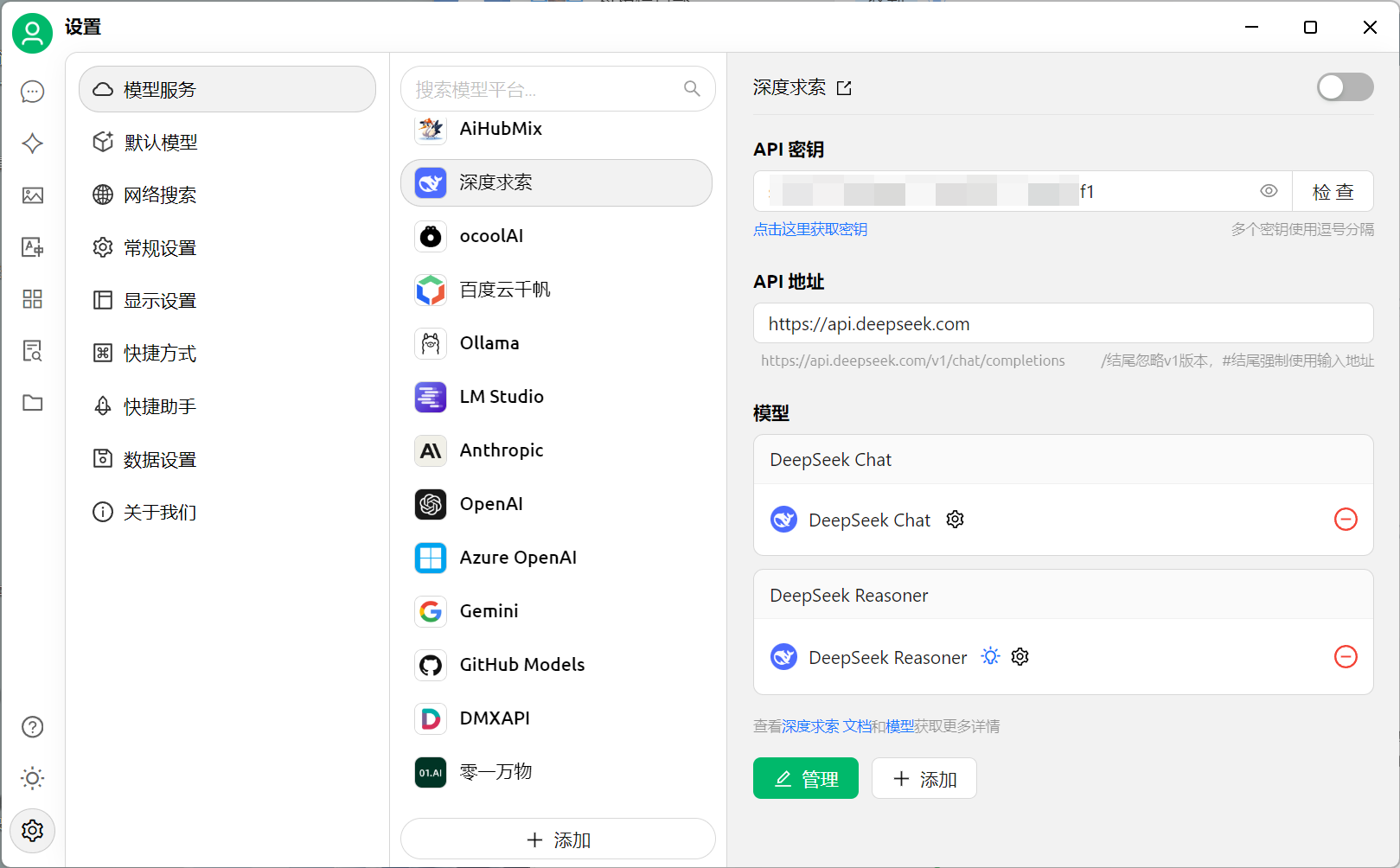

第二步:配置Cherry studio 模型服务

点击Cherry Studio左下角的设置按钮 ,点开模型服务,选中深度求索后输入刚才复制保存的key,点击检查,出现连接成功的提示后,点击打开右上角的开关按钮,Deepseek模型就已经配置好了。

需要说明的是,DeepSeek模型目前只能实现对话和推理,无法对本地的文件进行向量化的嵌入,如果你想实现将本地文件作为知识库提供给大模型作为上下文,你还需要配置支持 Text-Embedding的模型,比如通义千问。

3.2 文本嵌入模型的配置

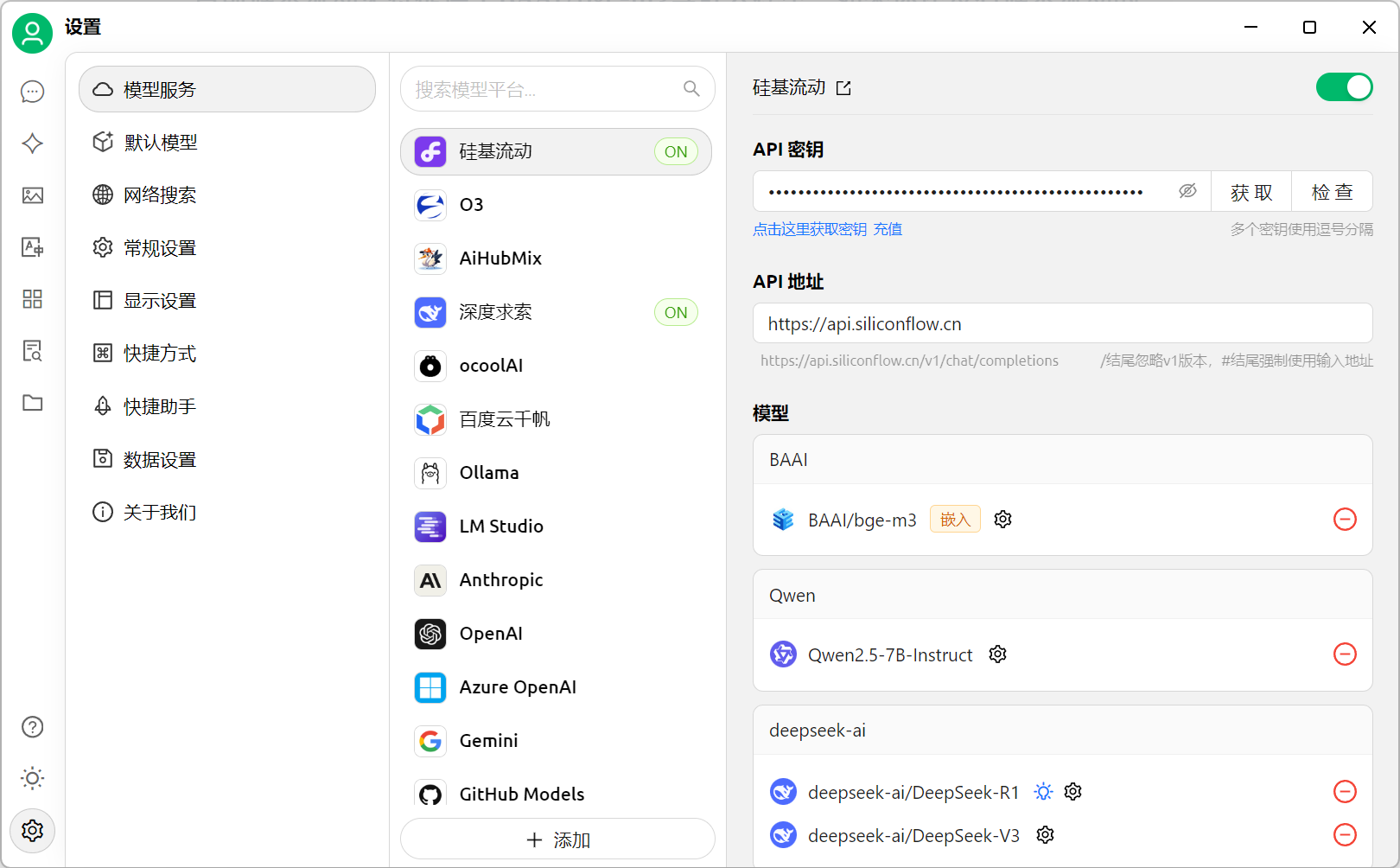

目前硅基流动免费提供了BAAI/bge-m3等嵌入模型,如果你还没有硅基流动的账号,赶紧点击下面的链接注册一个吧,现在注册,就赠送2000万Tokens的额度:

创建好账号后,我们首先要创建一个API key ,复制保存后来到cherry studio进行模型配置。

嵌入模型的配置过程与上一章配置deepseek对话和推理模型的过程类似,不再重复。

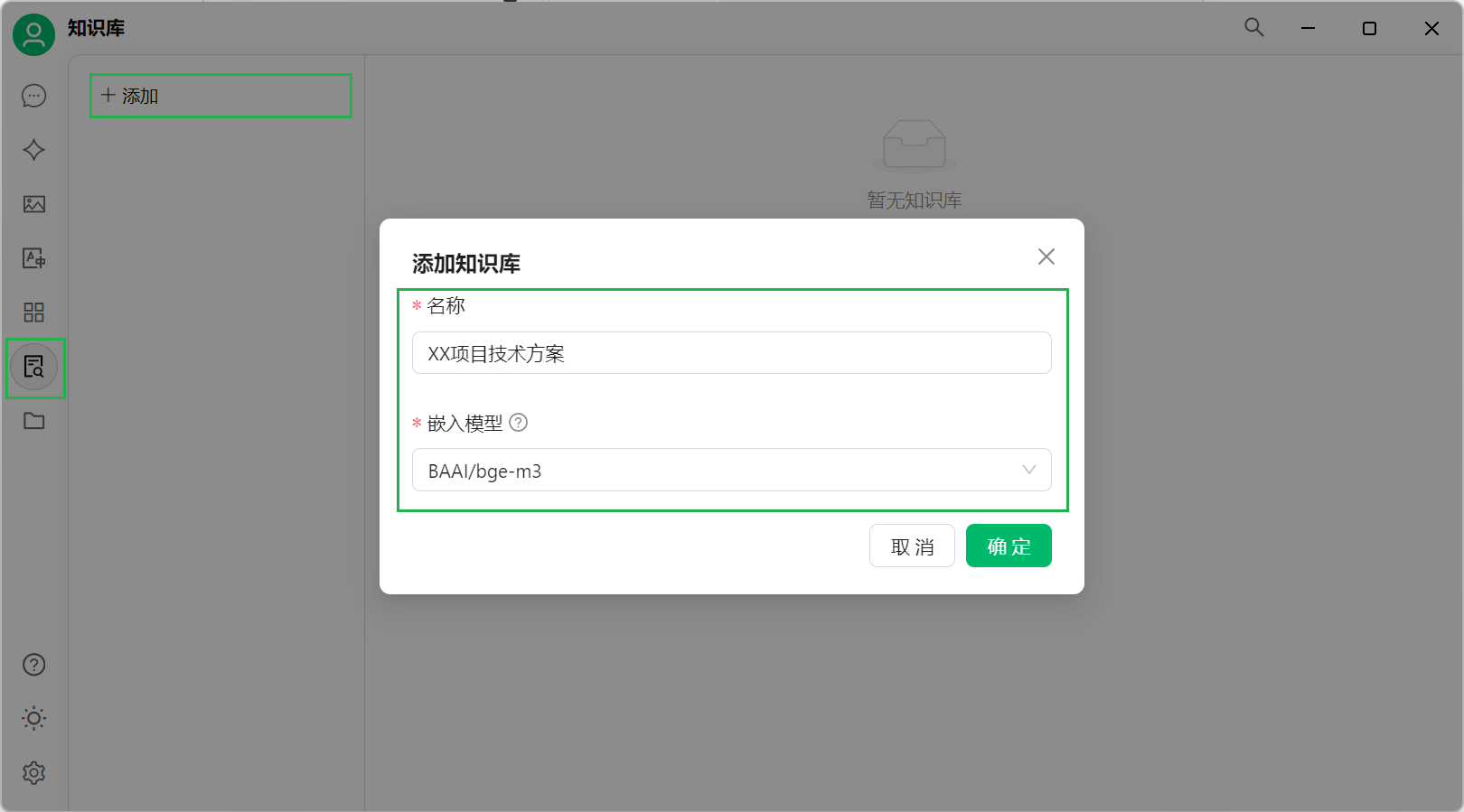

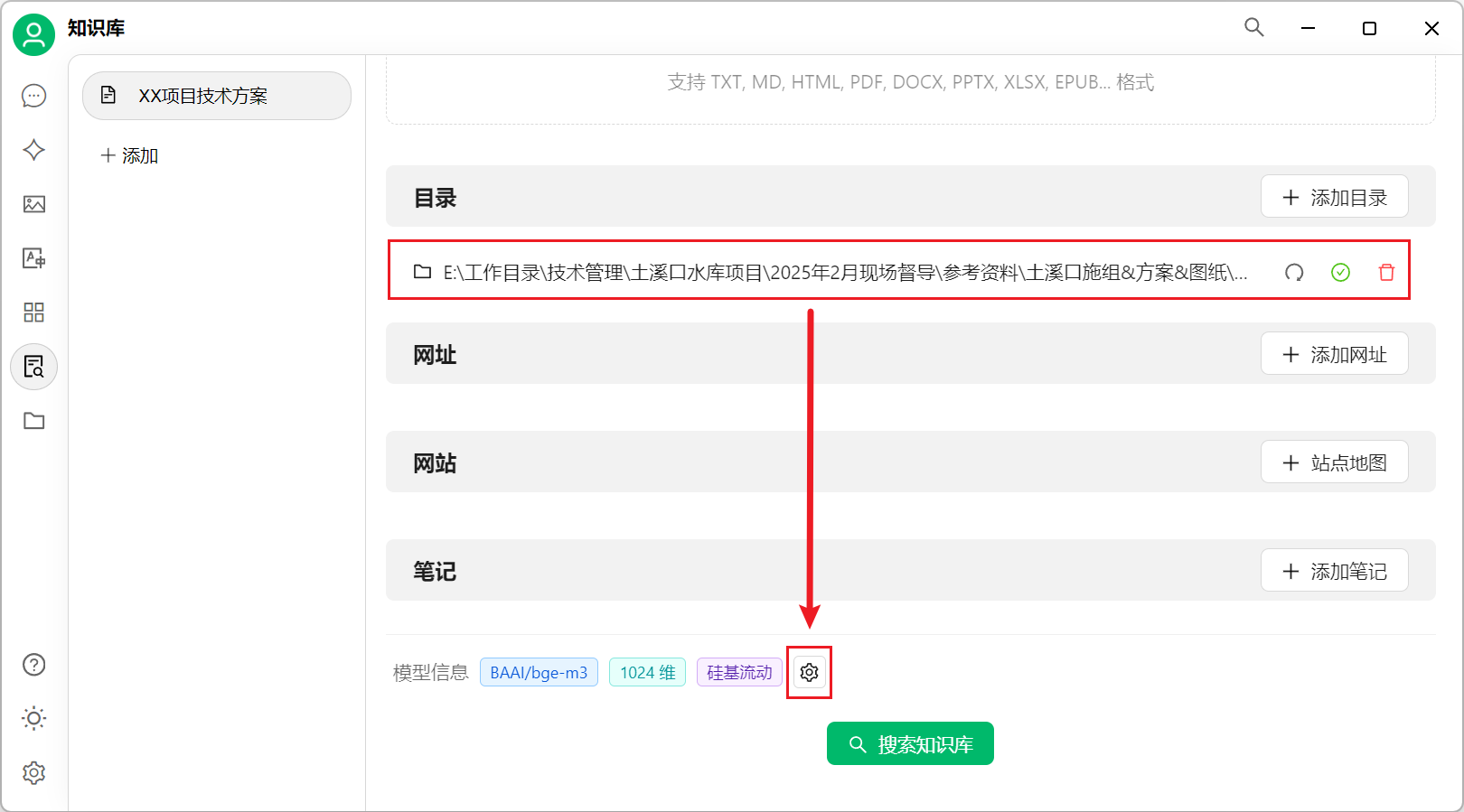

四、创建知识库

接下来,以创建XX项目技术方案知识库为例,演示Cherry Studio创建知识库的过程:点击左侧的知识库按钮,点击添加后输入知识库名称,如XX项目技术方案,选择嵌入模型BAAI/bge-m3后点击确定。

Cherry Studio支持从文件、目录、网址、网站、笔记创建知识库,用户根据自己的需要选择就好。

我将本地电脑上存放施工方案的目录 添加进知识库:

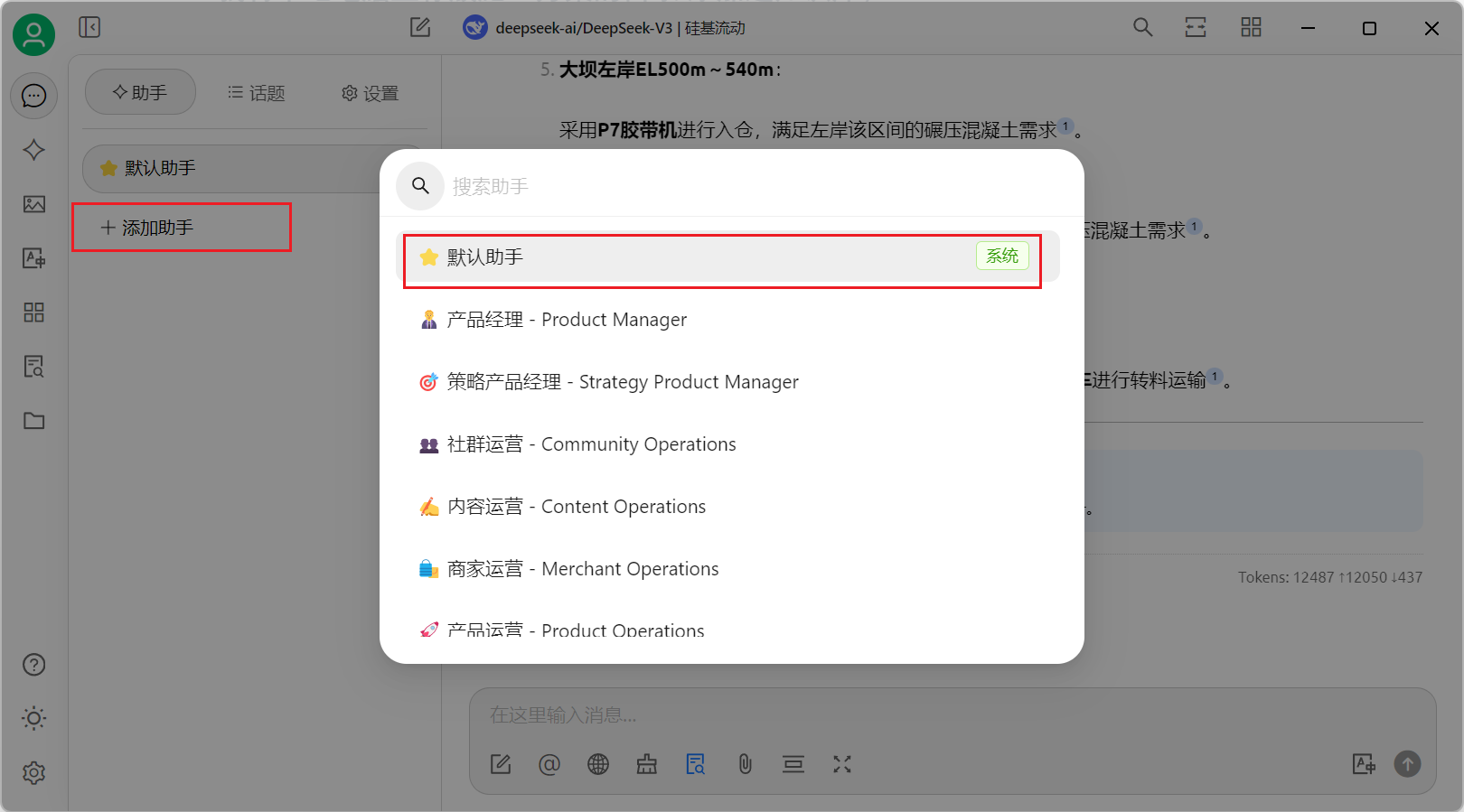

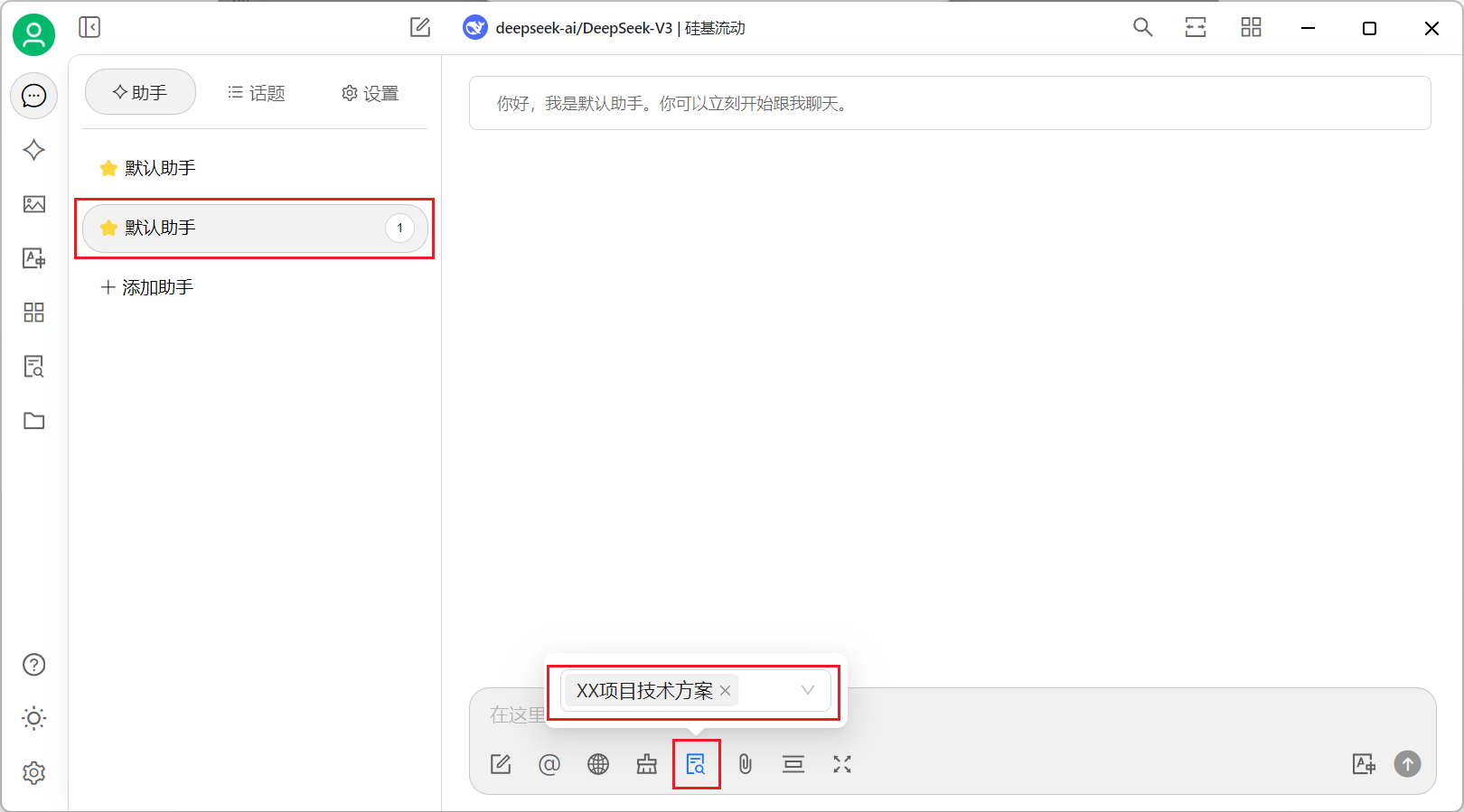

添加完成后,点击设置按钮配置知识库,保持默认点击确定。点击软件左侧的助手按钮,添加一个默认助手,并为他设置提示词,如:

你是一名水电站施工领域的权威专家,在大坝施工、厂房混凝土浇筑、闸门安装、混凝土生产等领域拥有丰富的经验,你能帮我回答任何和上述领域相关的问题。

为新添加的默认助手挂载刚添加的知识库:

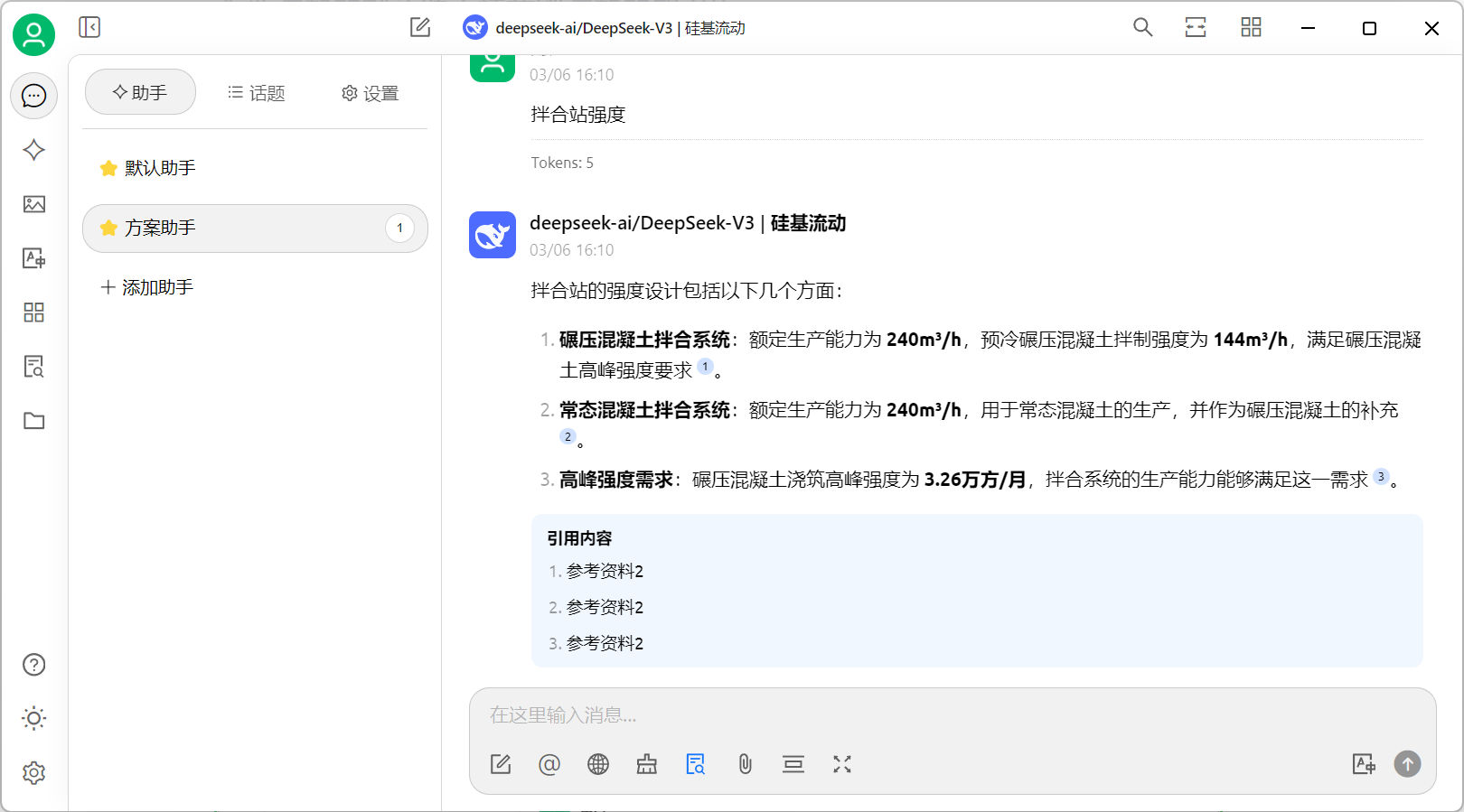

尝试使用deepseek返回本地知识库中的知识: